V tem blogu bomo obravnavali spodaj navedeno vsebino:

- Kako prilagoditi generiranje besedila z nalaganjem modela s funkcijo »cevovoda« iz Transformers?

- Kako uporabiti model na osnovi transformatorja za ustvarjanje besedila v PyTorchu?

- Kako uporabiti model na osnovi transformatorja za generiranje besedila v TensorFlow?

Kako prilagoditi generiranje besedila z nalaganjem modela s funkcijo »cevovoda« iz Transformers?

' cevovod ” se uporablja za samodejni prenos predhodno usposobljenega modela AI v skladu z zahtevami uporabnika. Za uporabo te posebne funkcije morajo uporabniki namestiti » transformatorji ” paketov. Ta paket omogoča dostop do najsodobnejših modelov, ki temeljijo na transformatorju in lahko izvajajo analizo razpoloženja ter več drugih Obdelava naravnega jezika (NLP) naloge.

Če si želite ogledati praktično predstavitev zgoraj opisanega scenarija, pojdite na spodnje korake!

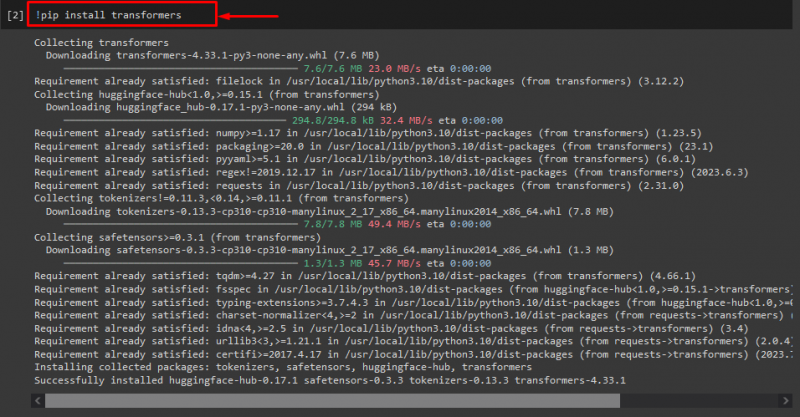

1. korak: Namestite pakete »transformers«.

Najprej izvedite ukaz “! pip” ukaz za namestitev transformatorskih paketov:

! pip namestite transformatorje

Kot lahko vidite, je bil navedeni paket uspešno nameščen:

2. korak: uvozite model, ki temelji na transformatorju

Nato uvozite zahtevani model na osnovi transformatorja. Če želite to narediti, najprej uvozite » cevovod ' funkcija od ' transformatorji ”. Nato uporabite uvoženo funkcijo in posredujte » generiranje besedila ' kot argument zanj skupaj z zahtevanim imenom modela ' gpt2 ”. Nato jih prenesite v » ustvariti ” spremenljivka:

od transformatorji uvoz cevovod

ustvariti = cevovod ( 'text-generation' , model = 'gpt2' )

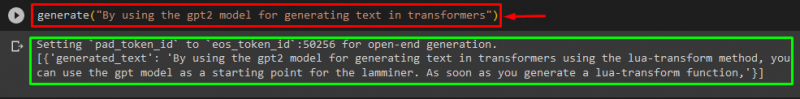

3. korak: ustvarite prilagojeno besedilo

Zdaj podajte želeno besedilo kot argument v ' ustvariti ”. Kot je prikazano spodaj:

ustvariti ( 'Z uporabo modela gpt2 za generiranje besedila v transformatorjih' )V skladu s posredovanim izhodom preneseni vnaprej usposobljeni » gpt3 ” model je bil uspešno ustvarjen besedilo:

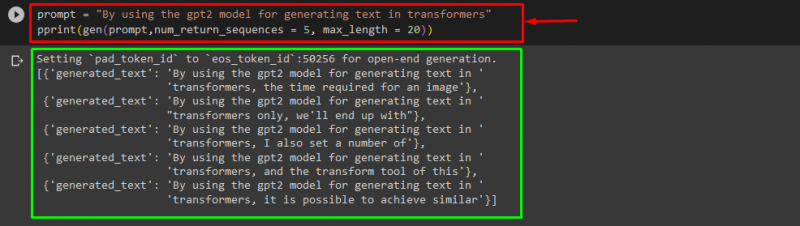

Uporabite lahko tudi druge argumente, kot so:

poziv = 'Z uporabo modela gpt2 za generiranje besedila v transformatorjih'tiskanje ( gen ( poziv , num_return_sequences = 5 , največja_dolžina = dvajset ) )

Tukaj:

- “ poziv ” se uporablja kot argument, ki zadrži vnos.

- “ num_return_sequence ” se uporablja za ustvarjanje števila zaporedij podanega besedila.

- “ največja_dolžina ” Argument se uporablja za določitev dolžine ustvarjenega besedila. V našem primeru je omejeno na ' 30 ” žetoni (besede ali ločila):

Opomba: Prilagojeno besedilo bo nadaljevanje navedenega poziva, ki temelji na podatkih o usposabljanju modela.

Kako uporabiti model na osnovi transformatorja za ustvarjanje besedila v PyTorchu?

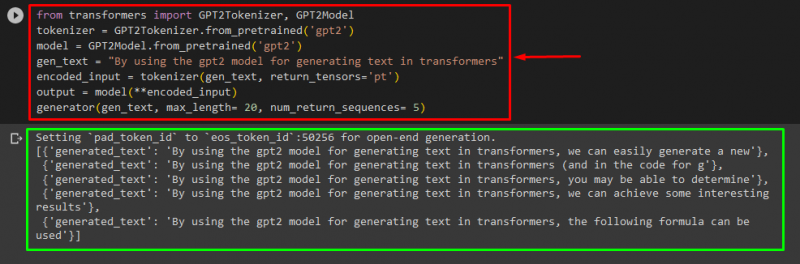

Uporabniki lahko tudi prilagodijo besedilo v » PyTorch ', ki je' Bakla ” ogrodje strojnega učenja. Uporablja se za različne aplikacije, kot sta NLP in računalniški vid. Če želite uporabiti transformatorski model za prilagajanje besedila v PyTorchu, najprej uvozite » GPT2Tokenizer « in » GPT2Model “ funkcije iz “ transformatorji ”:

od transformatorji uvoz GPT2Tokenizer , GPT2ModelNato uporabite » GPT2Tokenizer ” tokenizer v skladu z našim želenim vnaprej usposobljenim modelom z imenom “ gpt2 ”:

tokenizer = GPT2Tokenizer. od_pretreniran ( 'gpt2' )Nato instanciranje uteži iz vnaprej usposobljenega modela:

model = GPT2Model. od_pretreniran ( 'gpt2' )Nato razglasite » gensko_besedilo «, ki vsebuje besedilo, ki ga želimo prilagoditi:

gensko_besedilo = 'Z uporabo modela gpt2 za generiranje besedila v transformatorjih'Zdaj prenesite ' gensko_besedilo « in » return_tensors='pt' « kot argument, ki bo ustvaril besedilo v PyTorchu in shranil ustvarjeno vrednost v » kodiran_vhod ” spremenljivka:

kodiran_vhod = tokenizer ( gensko_besedilo , povratni_tenzorji = 'pt' )Na koncu prenesite ' kodiran_vhod ', ki hrani prilagojeno besedilo v ' model ' kot parameter in dobite rezultat z uporabo ' največja_dolžina ' argument, ki je nastavljen na ' dvajset «, ki označuje, da bo ustvarjeno besedilo omejeno na podane žetone, » num_return_sequences ', ki je nastavljen na ' 5 «, ki kaže, da se bo ustvarjeno besedilo zanašalo na 5 zaporedij besedila:

izhod = model ( **kodiran_vhod )generator ( gensko_besedilo , največja_dolžina = dvajset , num_return_sequences = 5 )

Izhod

Kako uporabiti model na osnovi transformatorja za generiranje besedila v TensorFlow?

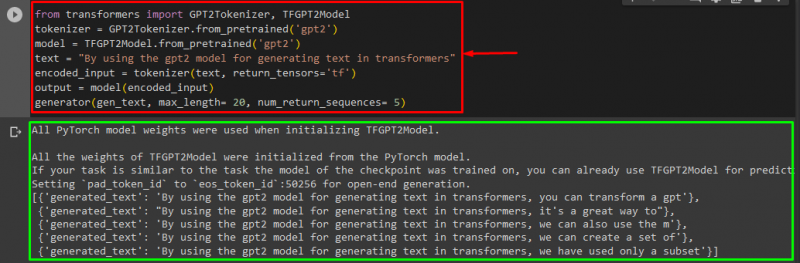

Za generiranje besedila v Transformers, ' TensorFlow ” uporabljajo se tudi okviri strojnega učenja. Če želite to narediti, najprej uvozite zahtevane funkcije, kot je » GPT2Tokenizer « in » TFGPT2Model ' Iz ' transformatorji ”. Preostali del kode je enak kot zgoraj, le uporabljamo ' TFGPT2Model ' namesto funkcije ' GPT2Model ”. Kot sledi:

od transformatorji uvoz GPT2Tokenizer , TFGPT2Modeltokenizer = GPT2Tokenizer. od_pretreniran ( 'gpt2' )

model = TFGPT2Model. od_pretreniran ( 'gpt2' )

besedilo = 'Z uporabo modela gpt2 za generiranje besedila v transformatorjih'

kodiran_vhod = tokenizer ( besedilo , povratni_tenzorji = 'tf' )

izhod = model ( kodiran_vhod )

generator ( gensko_besedilo , največja_dolžina = dvajset , num_return_sequences = 5 )

Kot lahko vidite, je bilo prilagojeno besedilo uspešno ustvarjeno:

To je to! Podrobneje smo opisali prilagajanje generiranja besedila v Transformers.

Zaključek

Za prilagajanje generiranja besedila v Transformers obstajajo različni načini, kot je nalaganje modela s funkcijo cevovoda z uporabo modela, ki temelji na transformatorju v ' PyTorch « in » TensorFlow ”, ki temeljijo na ogrodjih strojnega učenja. V tem priročniku smo ponudili kratke informacije in praktično predstavitev prilagajanja generiranja besedila v Transformers.