Ta vodnik bo prikazal postopek uporabe grafa znanja pogovorov v LangChain.

Kako uporabljati pogovorni grafikon znanja v LangChainu?

The PogovorKGSpomin knjižnico je mogoče uporabiti za ponovno ustvarjanje pomnilnika, ki ga je mogoče uporabiti za pridobitev konteksta interakcije. Če se želite naučiti postopka uporabe grafa znanja pogovorov v LangChainu, preprosto pojdite skozi navedene korake:

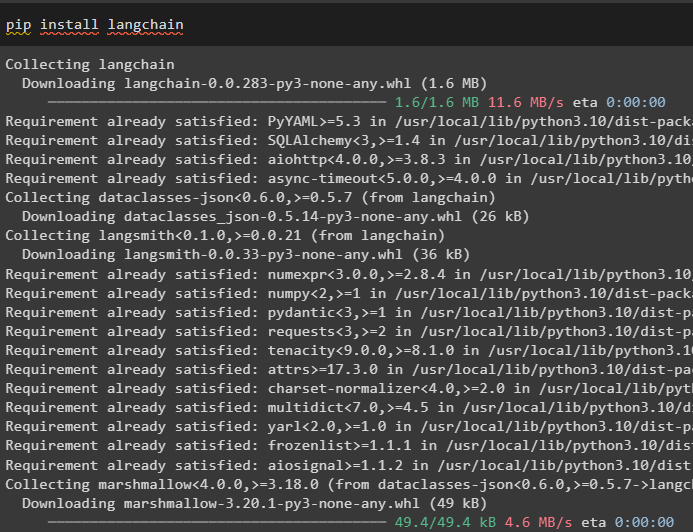

1. korak: Namestite module

Najprej začnite s postopkom uporabe grafa znanja pogovora z namestitvijo modula LangChain:

pip namestite langchain

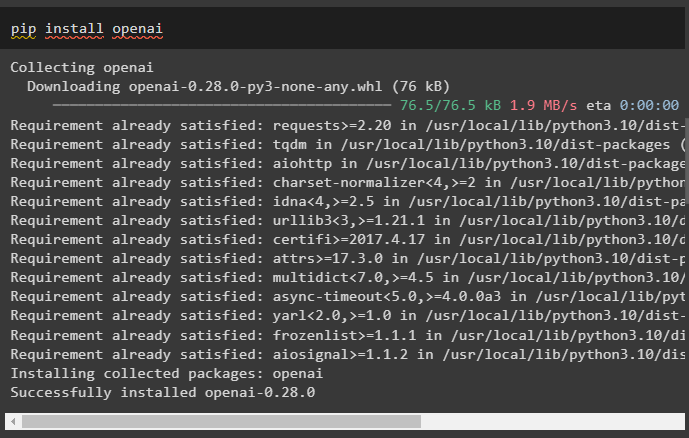

Namestite modul OpenAI, ki ga je mogoče namestiti z ukazom pip, da pridobite njegove knjižnice za gradnjo velikih jezikovnih modelov:

pip namestite openai

zdaj, nastavite okolje z uporabo ključa OpenAI API, ki ga je mogoče ustvariti iz njegovega računa:

uvoz ti

uvoz getpass

ti . približno [ 'OPENAI_API_KEY' ] = getpass . getpass ( 'Ključ API OpenAI:' )

2. korak: Uporaba pomnilnika z LLM

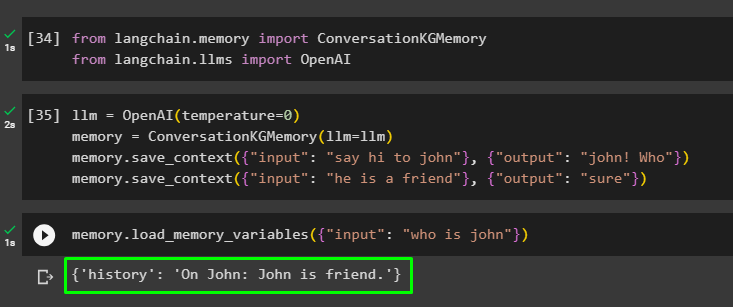

Ko so moduli nameščeni, začnite uporabljati pomnilnik z LLM tako, da uvozite zahtevane knjižnice iz modula LangChain:

od Langchain. spomin uvoz PogovorKGSpominod Langchain. llms uvoz OpenAI

Zgradite LLM z metodo OpenAI() in konfigurirajte pomnilnik z uporabo PogovorKGSpomin () metoda. Po tem shranite predloge pozivov z uporabo več vnosov z njihovimi ustreznimi odzivi za usposabljanje modela na teh podatkih:

llm = OpenAI ( temperaturo = 0 )spomin = PogovorKGSpomin ( llm = llm )

spomin. shrani_kontekst ( { 'vnos' : 'pozdravi john' } , { 'izhod' : 'janez! kdo' } )

spomin. shrani_kontekst ( { 'vnos' : 'on je prijatelj' } , { 'izhod' : 'seveda' } )

Preizkusite pomnilnik tako, da naložite spominske_spremenljivke () z uporabo poizvedbe, povezane z zgornjimi podatki:

spomin. load_memory_variables ( { 'vnos' : 'kdo je john' } )

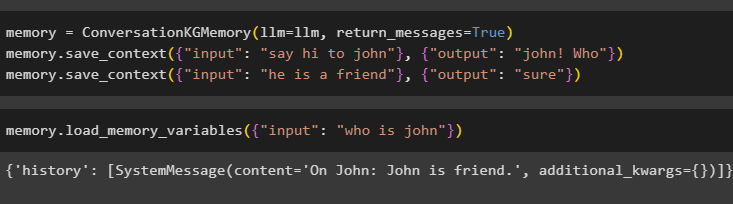

Konfigurirajte pomnilnik z metodo ConversationKGMemory() z povratna_sporočila argument za pridobitev tudi zgodovine vnosa:

spomin = PogovorKGSpomin ( llm = llm , povratna_sporočila = Prav )spomin. shrani_kontekst ( { 'vnos' : 'pozdravi john' } , { 'izhod' : 'janez! kdo' } )

spomin. shrani_kontekst ( { 'vnos' : 'on je prijatelj' } , { 'izhod' : 'seveda' } )

Preprosto preizkusite pomnilnik tako, da podate vhodni argument z njegovo vrednostjo v obliki poizvedbe:

spomin. load_memory_variables ( { 'vnos' : 'kdo je john' } )

Zdaj preizkusite spomin tako, da postavite vprašanje, ki ni omenjeno v podatkih o vadbi, in model nima pojma o odgovoru:

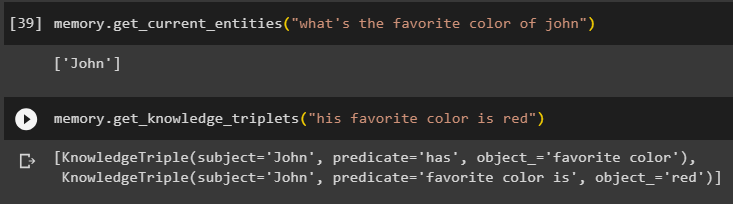

spomin. get_current_entities ( 'katera je Johnova najljubša barva' )Uporabi dobi_trojčke_znanja () z odgovorom na prej zastavljeno poizvedbo:

spomin. dobi_trojčke_znanja ( 'njegova najljubša barva je rdeča' )

3. korak: Uporaba pomnilnika v verigi

Naslednji korak uporabi pogovorni pomnilnik z verigami za izdelavo modela LLM z uporabo metode OpenAI(). Po tem konfigurirajte predlogo poziva z uporabo strukture pogovora in besedilo bo prikazano med pridobivanjem izhoda po modelu:

llm = OpenAI ( temperaturo = 0 )od Langchain. pozive . poziv uvoz PromptTemplate

od Langchain. verige uvoz ConversationChain

predlogo = '''To je predloga za interakcijo med človekom in strojem

Sistem je model AI, ki lahko govori ali pridobiva informacije o več vidikih

Če ne razume vprašanja ali nima odgovora, to preprosto pove

Sistem izvleče podatke, shranjene v razdelku »Specific«, in ne halucinira

Specifično:

{zgodovina}

Pogovor:

Človek: {input}

AI:'''

#Konfigurirajte predlogo ali strukturo za zagotavljanje pozivov in prejemanje odgovora iz sistema AI

poziv = PromptTemplate ( vhodne_spremenljivke = [ 'zgodovina' , 'vnos' ] , predlogo = predlogo )

pogovor_z_kg = ConversationChain (

llm = llm , verbose = Prav , poziv = poziv , spomin = PogovorKGSpomin ( llm = llm )

)

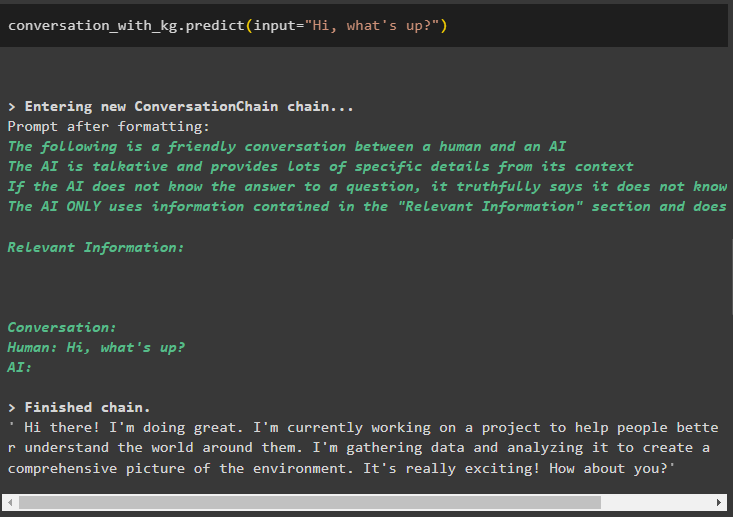

Ko je model ustvarjen, preprosto pokličite pogovor_z_kg model z uporabo metode predict() s poizvedbo, ki jo vpraša uporabnik:

pogovor_z_kg. napovedati ( vnos = 'Živjo, kaj dogaja?' )

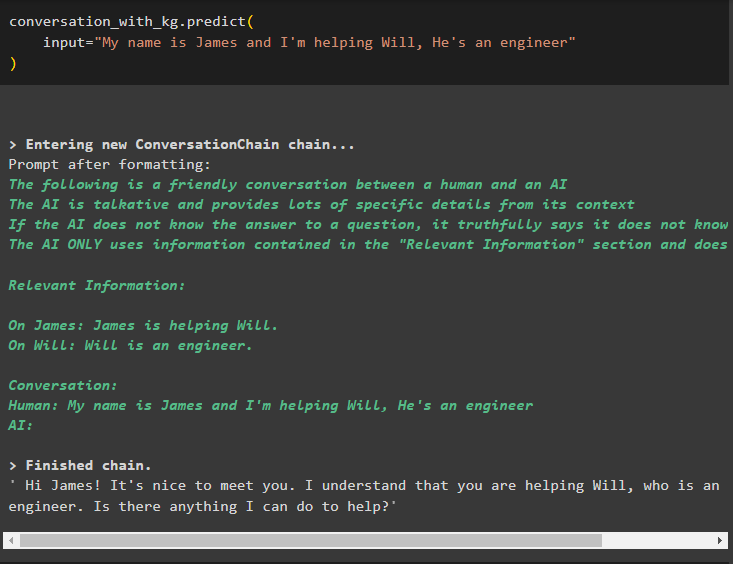

Zdaj usposobite model z uporabo pomnilnika pogovorov, tako da podate informacije kot vhodni argument za metodo:

pogovor_z_kg. napovedati (vnos = 'Ime mi je James in pomagam Willu, on je inženir'

)

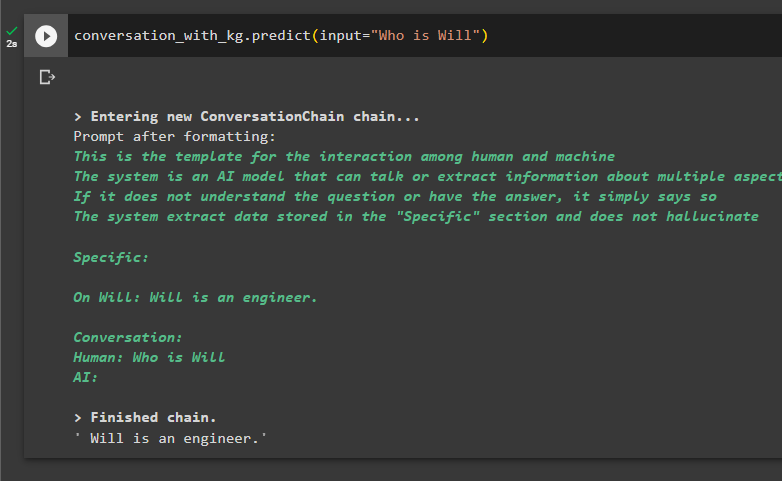

Tukaj je čas, da preizkusite model tako, da zahtevate, da poizvedbe izvlečejo informacije iz podatkov:

pogovor_z_kg. napovedati ( vnos = 'Kdo je Will' )

To je vse o uporabi grafa znanja pogovorov v LangChainu.

Zaključek

Če želite uporabiti graf znanja pogovorov v LangChain, namestite module ali ogrodja za uvoz knjižnic za uporabo metode ConversationKGMemory(). Po tem zgradite model z uporabo pomnilnika za izgradnjo verig in pridobivanje informacij iz podatkov o usposabljanju, navedenih v konfiguraciji. Ta priročnik je podrobneje predstavil postopek uporabe grafa znanja o pogovoru v LangChainu.